Meta dévoile SAM 2, son IA de reconnaissance d’objets appliquée aux images et vidéos

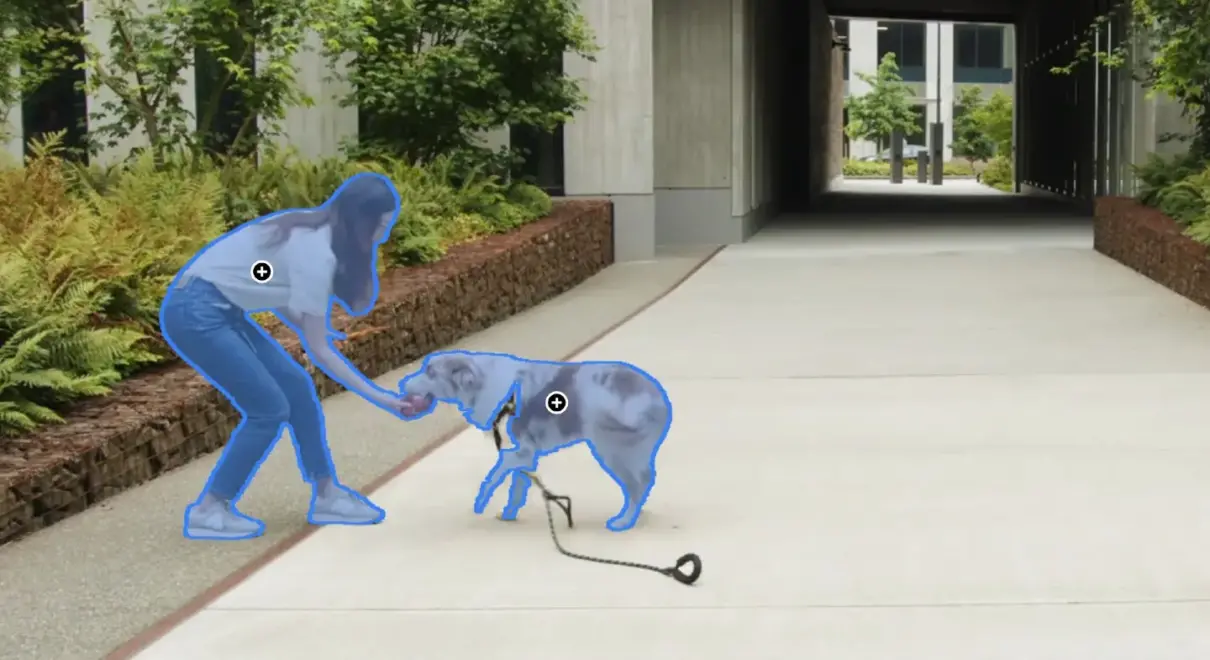

Meta a introduit SAM 2, la nouvelle version de son modèle « Segment Anything Model », qui permet la segmentation d’objets en temps réel à l’aide de prompts dans les images et les vidéos.

SAM 2 surpasse les performances des modèles précédents, notamment en matière de précision de segmentation d’images et de vidéos, tout en nécessitant trois fois moins d’interactions humaines. Ce modèle est capable de segmenter tout objet dans tout contenu visuel, même ceux qu’il n’a jamais vus auparavant, sans adaptation spécifique.

Conformément à son approche open source de l’IA, Meta a choisi de rendre ce modèle accessible au public sous une licence Apache 2.0, permettant ainsi à chacun de l’utiliser pour créer ses propres expériences.

Meta partage également le dataset SA-V sous une licence CC BY 4.0 (51 000 vidéos du monde réel et plus de 600 000 masques spatio-temporels) et publie une démo en ligne permettant de tester le modèle en action : https://sam2.metademolab.com

Pourquoi SAM 2 ?

Les cas d’utilisation de la segmentation vidéo, tels que la réalité mixte ou les véhicules autonomes, nécessitent une segmentation précise des objets dans les vidéos, exigeant un modèle capable de gérer à la fois les images et les vidéos.Vraie anecdote : lors de nos premiers échanges internes autour de ce POC, nous n’avons pas su trancher entre SwiftUI (pour les néophytes : l’environnement de développement d’interfaces iOS, iPadOS, watchOS, tvOS, visionOS et macOS) et Unity (moteur 3D de référence pour le développement d’applications 3D et XR, à l’instar d’Unreal Engine).

Ainsi, SAM 2 permet une segmentation vidéo 8,4 fois plus rapide que l’annotation manuelle par image.

Fonctionnement de SAM 2

Une tâche de segmentation visuelle promptable a été conçue pour étendre la segmentation d’image au domaine vidéo, de manière flexible et interactive.

SAM 2 a été entraîné à recevoir des prompts (points, boîtes, ou masques) dans n’importe quelle image d’une vidéo pour définir un masque spatio-temporel, appelé « masklet ».

SAM 2 prédit immédiatement un masque sur l’image actuelle et le propage temporellement pour générer le masklet sur l’ensemble des images de la vidéo.

Ce masklet initial peut être affiné de manière itérative en fournissant des prompts supplémentaires dans n’importe quelle image, jusqu’à obtenir le masklet souhaité.

Quelques cas d’usage

- Montage vidéo

Manipulation visuelle, ajout d’effets, suppression des éléments perturbateurs et de l’arrière-plan : tout cela est faisable en temps réel grâce à SAM 2. - Véhicules autonomes

Meilleure détection d’obstacles, amélioration de la navigation… - Médecine

Meilleures analyse anatomique et détection des tumeurs. - Surveillance

Détection de comportements suspects, analyse des foules…

Limitations actuelles

La segmentation d’objets présente plusieurs défis majeurs. La perte de suivi survient lors de changements brusques de caméra ou après des occlusions prolongées, rendant la réidentification des objets incertaine. De plus, la confusion entre objets similaires dans des scènes encombrées entraîne des erreurs d’attribution, affectant la précision des modèles.

La capture des détails fins et des objets en mouvement rapide reste difficile, provoquant des prédictions instables. Lorsque plusieurs objets sont segmentés simultanément, l’efficacité diminue, augmentant le risque d’interférences. Par ailleurs, l’absence de lissage temporel entre les frames génère des incohérences dans la segmentation vidéo.

Enfin, une intervention humaine demeure nécessaire pour affiner les segments et corriger les erreurs, limitant l’automatisation complète des processus de segmentation.

Ressources

- Télécharger le modèle SAM 2 :

https://github.com/facebookresearch/segment-anything-2 - Accéder à la base de données SA-V :

https://ai.meta.com/datasets/segment-anything-video - Lire l’article de recherche :

https://ai.meta.com/research/publications/sam-2-segment-anything-in-images-and-videos - Tester la démo SAM 2 sur le web :

https://sam2.metademolab.com - Visiter le site de SAM 2 :

https://ai.meta.com/SAM2